Acelerando la IA: los chips de vanguardia que impulsan la revolución informática

|

| Los chips de computadora se están adaptando para realizar más cálculos paralelos y más rápidos para aplicaciones de inteligencia artificial. Fuente: Google |

Los ingenieros están aprovechando los poderes de las unidades de procesamiento de gráficos (GPU) y más, con una serie de trucos para satisfacer las demandas computacionales de la inteligencia artificial.

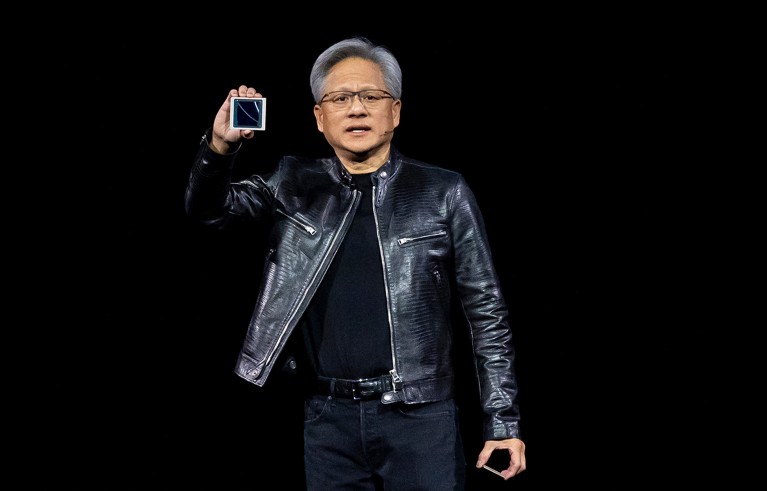

04 junio 2024.- En marzo de este año, una multitud entusiasta de 12.000 personas llenó un estadio en San José, California. "Espero que se den cuenta de que esto no es un concierto", bromeó Jensen Huang, director ejecutivo de la empresa fabricante de chips Nvidia en la cercana Santa Clara.

Durante la siguiente media hora, Huang preparó a la multitud para escuchar las últimas noticias sobre las unidades de procesamiento de gráficos (GPU), el chip informático característico de su empresa, que ha sido clave para los avances de la inteligencia artificial (IA) durante la última década. Huang levantó el modelo 2022 de la compañía, el 'superchip' Hopper. "Hopper cambió el mundo", dijo. Luego, después de una pausa dramática, reveló otro rectángulo negro brillante del tamaño de una nota Post-it: "Este es Blackwell". La multitud aplaudió.

En 2022, Hopper venció a la competencia en todas las categorías, desde clasificación de imágenes hasta reconocimiento de voz, en MLPerf, una batería de pruebas a las que a veces se hace referencia como las olimpíadas de la IA. Tan pronto como llegó al mercado, Hopper se convirtió en el chip preferido de las empresas que buscaban potenciar su IA. Ahora Nvidia promete que Blackwell será varias veces más rápido que su predecesor y nos llevará al siguiente nivel de rendimiento mediante una combinación de más caballos de fuerza y también cómo los chips se comunican entre sí.

Mientras las esperanzas y preocupaciones giran en torno al impacto de la IA , el mercado de chips de IA sigue creciendo. Nvidia suministra actualmente más del 80% de ellos; en 2023, vendió 550.000 chips Hopper. Los potentes chips, que costaban al menos 30.000 dólares cada uno, se destinaron a centros de datos, en lugar de a ordenadores personales. Este año, el valor de mercado de la empresa se disparó a más de 2 billones de dólares, lo que la convierte en la tercera empresa más valorada del mundo, por delante de gigantes como Amazon y Alphabet, la empresa matriz de Google.

El director ejecutivo de Nvidia, Jensen Huang, sostiene la nueva unidad de procesamiento de gráficos Blackwell de la empresa de tecnología. Fuente: David Paul Morris/Bloomberg/Getty

El chip Blackwell de Nvidia es parte de una ola de desarrollos de hardware, resultado de los esfuerzos de las empresas por seguir el ritmo y apoyar la revolución de la IA. Durante la última década, gran parte del avance en IA no se debe tanto a ingeniosos trucos de codificación sino al simple principio de que cuanto más grande, mejor . Los modelos de lenguajes grandes se han entrenado cada vez más en conjuntos de datos cada vez mayores, lo que requiere cada vez más potencia informática. Según algunas estimaciones, el último modelo de la empresa estadounidense OpenAI, GPT-4, requirió 100 veces más potencia informática para entrenar que su predecesor.

Empresas como Meta han construido centros de datos que dependen de las GPU de Nvidia. Otros, incluidos Google e IBM , junto con una gran cantidad de empresas más pequeñas, han diseñado sus propios chips de IA. Meta ahora también está funcionando por sí solo. Mientras tanto, los investigadores están experimentando con una variedad de diseños de chips, incluidos algunos optimizados para funcionar en dispositivos más pequeños. A medida que la IA va más allá de los centros de computación en la nube y llega a los dispositivos móviles, no parece que las GPU ya sean suficientes.

Todos estos chips tienen algo en común: varios trucos, incluida la computación en paralelo, una memoria más accesible y taquigrafía numérica, que les ayudan a superar las barreras de velocidad de la computación convencional.

Cambio de chip

Gran parte de la revolución del aprendizaje profundo de la última década puede atribuirse a un alejamiento del caballo de batalla convencional de la informática: la unidad central de procesamiento (CPU).

Una CPU es esencialmente una pequeña máquina que sigue órdenes. En el nivel más básico, una CPU ejecuta instrucciones activando transistores, interruptores eléctricos simples que representan '1' como encendido y '0' como apagado. Con sólo esta operación binaria, los transistores pueden realizar cálculos increíblemente complejos.

La potencia y la eficiencia de una CPU dependen principalmente del tamaño de sus transistores: los transistores más pequeños giran más rápido y se pueden empaquetar de manera más densa en un chip. Hoy en día, los transistores más avanzados miden apenas 45 × 20 nanómetros, no mucho más que sus componentes atómicos. Las CPU de primera línea contienen más de 100 millones de transistores en un milímetro cuadrado y pueden realizar alrededor de un billón de flops (operaciones de punto flotante por segundo).

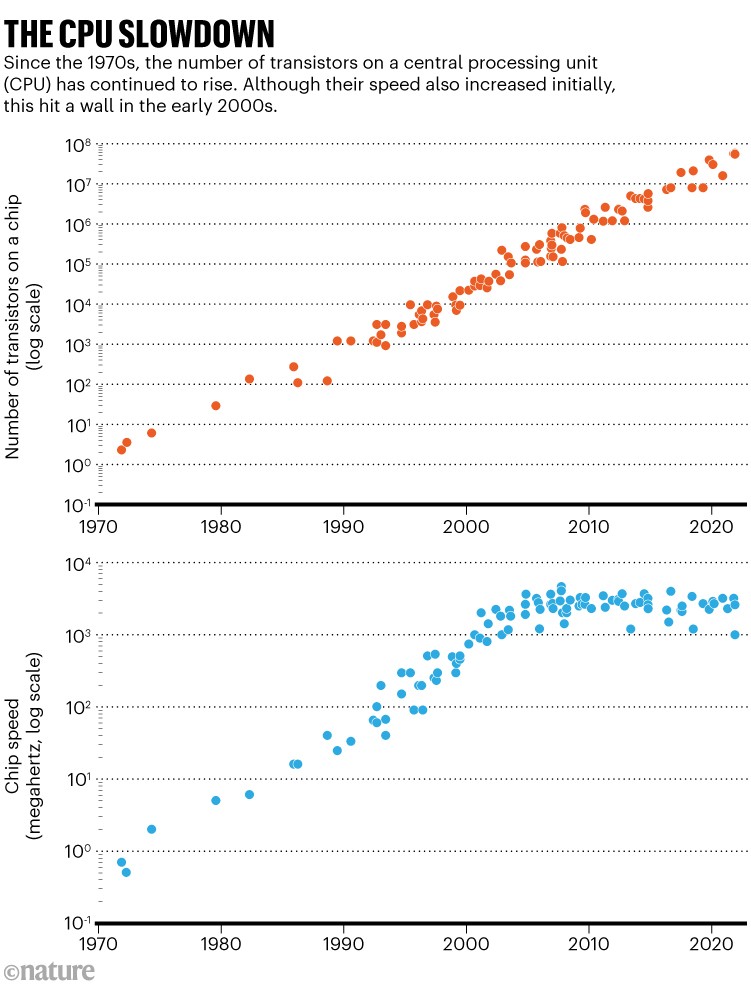

Las CPU han mejorado exponencialmente desde la década de 1970. A medida que los transistores se redujeron, su densidad en un chip se duplicó cada dos años (una tendencia conocida como ley de Moore), y los transistores más pequeños se volvieron más rápidos (como resultado de una tendencia llamada escala de Dennard). El progreso en las CPU fue tan rápido que hizo inútil el diseño personalizado de otros tipos de chips.

Pero alrededor de 2005, los transistores más pequeños dejaron de ser más rápidos y, en los últimos años, los ingenieros comenzaron a preocuparse de que no pudieran fabricar transistores mucho más pequeños , ya que los dispositivos comenzaron a chocar con las leyes fundamentales de la física .

Desaceleración de la CPU. Fuente: Karl Rupp

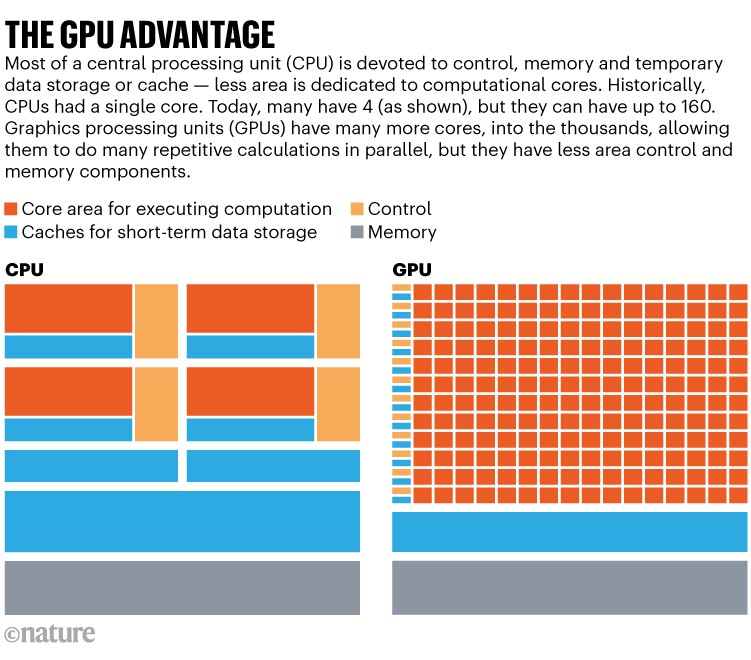

La desaceleración en el progreso de la CPU llevó a los ingenieros informáticos a considerar seriamente otros tipos de chips. Las primeras versiones de GPU existían desde finales de la década de 1970 y estaban diseñadas para realizar cálculos repetitivos para videojuegos, como reproducir el color de los píxeles en la pantalla lo más rápido posible. Mientras que las CPU procesan instrucciones de forma secuencial, las GPU procesan más instrucciones en paralelo.

En general, las CPU tienen unos pocos 'núcleos' potentes en los que se realizan los cálculos. Cada una de estas unidades de procesamiento individuales recibe instrucciones y está respaldada por múltiples cachés que almacenan datos a corto plazo. Esta arquitectura hace que las CPU sean ideales para cálculos complejos.

Las GPU, por el contrario, tienen cientos o miles de núcleos más pequeños, cada uno de ellos respaldado por menos sistemas auxiliares, como cachés. Tener muchos núcleos más pequeños permite a las GPU realizar muchos cálculos simples y repetitivos en paralelo mucho más rápido que una CPU.

Las ventajas de la GPU. Fuente: Universidad de Cornell

En 2012, Geoffrey Hinton, científico informático de la Universidad de Toronto y uno de los primeros defensores de las redes neuronales (algoritmos inspirados en el cerebro), desafió a su entonces alumno Alex Krizhevsky a ganar el concurso anual ImageNet, con el objetivo de entrenar una computadora. Identificar correctamente imágenes de objetos cotidianos. En ese momento, los programas que usaban CPU lograban una precisión del 75%, en el mejor de los casos. Krizhevsky se dio cuenta de que una IA de red neuronal entrenada con GPU podría funcionar mejor, dado que el pan de cada día del aprendizaje automático son cálculos simples y repetitivos.

Krizhevsky y sus colaboradores 1 utilizaron dos GPU para entrenar su red neuronal, llamada AlexNet. Su IA tenía 60 millones de parámetros (variables internas que los modelos de IA utilizan para hacer predicciones), algo sin precedentes en ese momento. AlexNet arrasó con la competencia, obteniendo un 85% de precisión y sorprendiendo al mundo con su capacidad para distinguir de manera confiable entre imágenes similares, como las de leopardos y jaguares. En uno o dos años, todos los participantes de ImageNet utilizaban GPU. Desde entonces, los investigadores de IA se han apoyado en gran medida en esos chips.

Aunque las GPU, al igual que las CPU, todavía están sujetas a las limitaciones de los transistores, su capacidad para calcular en paralelo les ha permitido acelerar las tareas de IA. Para entrenar el modelo de lenguaje grande GPT-3 , que tiene 175 mil millones de parámetros, los investigadores de OpenAI tuvieron que ejecutar 1.024 GPU durante un mes seguido, lo que costó varios millones de dólares. En total, esas GPU realizaron 10.23 flops . El mismo entrenamiento habría llevado cientos o miles de veces más tiempo en CPU comparables. Con más computación, se podía entrenar una red más grande. GPT-4, por ejemplo, lanzado en marzo de 2023, tiene la asombrosa cifra de 1,8 billones de parámetros, diez veces más que su predecesor.

Aunque las GPU han sido fundamentales para la revolución de la IA, no son el único espectáculo en la ciudad. A medida que las aplicaciones de IA han proliferado, también lo han hecho los chips de IA.

Un paso más

A veces no hay tiempo suficiente para introducir instrucciones en un chip. Los conjuntos de puertas programables en campo (FPGA) están diseñados para que un ingeniero informático pueda programar los circuitos del chip para que sigan órdenes específicas en lugar de instrucciones. Mientras un chip como una CPU o una GPU debe esperar instrucciones externas, una FPGA simplemente lo hace.

Una FPGA es “como una caja de Legos”. Un ingeniero puede construir un FPGA circuito por circuito en cualquier diseño que pueda imaginar, ya sea para un sensor de lavadora o IA para guiar un vehículo autónomo . Sin embargo, en comparación con los chips de IA que tienen circuitos no ajustables, como las GPU, los FPGA pueden ser más lentos y menos eficientes.

Empresas como Altera, una subsidiaria de Intel en San José, comercializan FPGA para una variedad de aplicaciones de inteligencia artificial, incluidas imágenes médicas, y los investigadores los han encontrado útiles para tareas específicas, como el manejo de datos en colisionadores de partículas. La fácil programación de los FPGA también los hace útiles para la creación de prototipos.

Aunque sería bueno simplemente poner una GPU completa en un teléfono móvil, los costes de energía y el precio lo hacen prohibitivo. Los chips de IA reducidos pueden respaldar la CPU del teléfono al manejar las tediosas tareas de las aplicaciones de IA, como el reconocimiento de imágenes, sin depender del envío de datos a la nube.

Quizás el trabajo más laborioso que tienen los chips de IA es multiplicar números. En 2010, Google tuvo un problema: la empresa quería realizar transcripciones de voz para una gran cantidad de usuarios diarios. Entrenar una IA para que lo manejara automáticamente habría requerido, entre otras tareas difíciles, multiplicar muchos números. Para ello, el desarrollo de un nuevo tipo de chip, la unidad de procesamiento tensorial (TPU), como plataforma para la IA de Google.

La TPU fue diseñada específicamente para la aritmética que sustenta la IA. Cuando la TPU recibe una instrucción, en lugar de realizar una operación, puede realizar más de 100.000. (La multitarea matemática de la TPU es el resultado de circuitos y software especialmente diseñados; hoy en día, muchas GPU creadas con aplicaciones de IA en mente, como Blackwell, tienen capacidades similares). La capacidad de ejecutar una enorme cantidad de operaciones con solo una necesidad limitada Esperar instrucciones permitió a Google acelerar muchos de sus proyectos de inteligencia artificial, no solo su servicio de transcripción de voz.

Para acelerar aún más los cálculos, muchos chips de IA, como los TPU y las GPU, utilizan una especie de taquigrafía digital. Las CPU normalmente realizan un seguimiento de los números en formato de 64 bits, es decir, 64 ranuras para un 0 o un 1, todas las cuales son necesarias para representar cualquier número determinado. Usar un formato de datos con menos bits puede reducir la precisión de los cálculos, por lo que los chips genéricos se quedan con 64.

Pero si puede lograr menos especificidad, “el hardware será más simple, más pequeño y de menor potencia”. Por ejemplo, enumerar una secuencia de ADN, en principio, requiere sólo un formato de 2 bits porque la información genética tiene cuatro posibilidades: las bases A, T, G o C (representadas como 00, 01, 10 u 11). Una FPGA se diseñó 2 para alinear datos genómicos usando un formato de 2 bits era 28 veces más rápida que una CPU comparable usando un formato de 64 bits. Para acelerar los cálculos de aprendizaje automático, los ingenieros han reducido la precisión de los chips; Los TPU se basan en un formato especializado de 16 bits. Para la última generación de chips, como Blackwell, los usuarios pueden incluso elegir entre una variedad de formatos, de 64 bits a 4 bits, el que mejor se adapte al cálculo que se debe realizar.

Chips Ahoy

Los chips de IA también están diseñados para evitar recordar demasiado. Transmitir datos de un lado a otro entre el microprocesador, en el que se realizan los cálculos, y el lugar donde se almacena la memoria puede consumir mucho tiempo y energía. Para combatir este problema, muchas GPU tienen enormes cantidades de memoria conectadas directamente a un solo chip: el Blackwell de Nvidia tiene alrededor de 200 gigabytes. Cuando se instalan chips de IA en un servidor, también pueden compartir memoria para facilitar la conexión en red entre chips individuales y requerir menos electricidad. Google ha conectado cerca de 9.000 TPU en un 'pod'.

El uso de electricidad (la carga de mover tantos electrones a través de circuitos) no es una preocupación menor. Puede ser difícil obtener cifras exactas, pero se estima que el entrenamiento del GPT-3 consumió 1.300 megavatios hora (MWh) de electricidad 3 . (El hogar promedio en el Reino Unido consume alrededor de 3 MWh al año). Incluso después de la capacitación, el uso de aplicaciones de IA puede ser un sumidero de energía. Aunque los avances en el diseño de chips pueden mejorar la eficiencia, los costes energéticos de la IA siguen aumentando año tras año a medida que los modelos crecen 4 .

El auge de los chips de IA, como las GPU, no significa el fin de las CPU. Más bien, las líneas entre incluso los tipos básicos de chips se están desdibujando: las CPU modernas son mejores en cálculos paralelos que las versiones anteriores, y las GPU se están volviendo más versátiles de lo que solían ser. Una versión del chip Blackwell de Nvidia empareja la GPU directamente con una CPU. La supercomputadora más poderosa del mundo, Frontier en el Laboratorio Nacional Oak Ridge en Tennessee, se basa en una combinación de CPU y GPU.

Dada la velocidad de los cambios en la última década, los investigadores dicen que es difícil predecir el futuro de los chips: podría incluir chips ópticos que utilicen luz en lugar de electrones 5 , 6 o chips de computación cuántica . Mientras tanto, algunos dicen que hacer que el público sea más consciente del hardware de IA podría ayudar a desmitificar el campo y corregir la percepción errónea de que la IA es todopoderosa.

En el fondo, todo son sólo cables y electrones. Es poco probable que se apoderen del mundo ya que podemos simplemente desconectarlos. La esperanza de que el hardware siga mejorando es importante ya que ayudará a acelerar las aplicaciones de la IA en la ciencia.

Fuente: Nature

Referencias

1. Krizhevsky, A., Sutskever, I. & Hinton, G. E. Commun. ACM 60, 84–90 (2017). Artículo

2. Guo, L., Lau, J., Ruan, Z., Wei, P. & Cong, J. in IEEE 27th Annu. Int. Symp. Field-Programmable Cust. Comput. Mach. (FCCM) 127–135 (IEEE, 2019).

3. Luccioni, A. S., Viguier, S. & Ligozat, A.-L. Preprint at arXiv https://doi.org/10.48550/arXiv.2211.02001 (2022).

4. Desislavov, R., Martínez-Plumed, F. & Hernández-Orallo, J. Sustain. Comput. Inform. Sys. 38, 100857 (2023). PubMed

5. Xu, Z. et al. Science 384, 202–209 (2024). Artículo

6. Nikkhah, V. et al. Nature Photon. 18, 501–508 (2024). Artículo

COMENTARIOS